python网络爬虫爬取数据

Python 网络爬虫:从网络中提取数据的利器 。

在当今数据驱动的时代,网络爬虫已成为从互联网浩瀚海洋中提取有价值数据的宝贵工具。 Python 凭借其强大的库和易于使用的语法,已成为构建网络爬虫的首选语言。

Web 爬虫 101

。网络爬虫本质上是一个程序,可以遍历和解析网页,从 HTML 代码中提取特定信息。它通过使用 HTTP 请求获取网页内容,解析 HTML 结构,并从中提取所需数据。

Python 网络爬虫的优势

。使用 Python 构建网络爬虫具有以下优势:

强大的库:如 Beautiful Soup、Scrapy 和 Requests,这些库可简化 HTML 解析和 HTTP 请求管理的过程。

易于使用:Python 的直观语法和广泛的文档使其易于学习和使用,即使对于初学者也是如此。

可扩展性:Python 网络爬虫可以轻松扩展,以处理大型数据集和复杂的网站。

使用 Python 提取数据

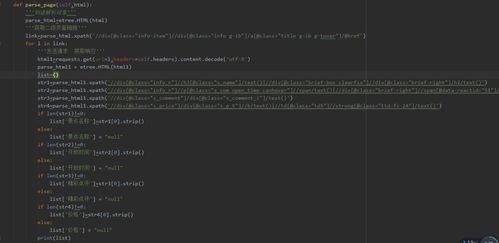

。以下是如何使用 Python 提取数据的简单示例:。

```python。

import requests。

from bs4 import BeautifulSoup。

url = 'https://example.com'。

response = requests.get(url)。

soup = BeautifulSoup(response.content, 'html.parser')。

data = soup.find_all('div', class_='product-name')。

for product in data:。

print(product.text)。

```。

这段代码从指定 URL 获取 HTML,使用 Beautiful Soup 解析 HTML,并提取所有具有类名“product-name”的 div 元素,其中包含产品名称。

结论

。Python 网络爬虫是获取网络数据、执行 Web 抓取和自动化任务的强大工具。凭借其易用性和强大的功能,Python 使开发人员能够轻松创建高效的爬虫,从互联网上提取有价值的信息。

。python 网络爬虫

Pytho 网络爬虫:使用 Pytho 轻松抓取网络数据

简介

网络爬虫,又称网络蜘蛛或网络机器人,是一种自动化程序,用于从网络上收集数据。它们通常用于信息提取、数据挖掘和网络分析等任务。使用 Pytho 编程语言构建网络爬虫相对容易,本文将指导你如何使用 Pytho 编写一个网络爬虫。

设置环境

要开始,你需要一个 Pytho 开发环境。你可以安装 Pytho、必要的库

python爬取网络数据代码

用 Pytho 爬取网络数据:终极指南

概述

在当今数据驱动的世界中,能够从网络上获取有价值的数据对于各种应用程序和分析至关重要。Pytho 因其易用性、强大的库和广泛的社区支持而成为网络爬取的理想语言。本文提供了一个分步指南,向你展示如何使用 Pytho 轻松有效地从网络中爬取数据。

库

Pytho 拥有许多优秀的库,可以简化网络爬取任务。的库包括:

- BeautifulSoup

- Scrapy

- Seleium

- Requests

步骤

要使用 Pytho 爬取网络数据,请遵循以下步骤:

1. 定义 URL 和请求类型

定义要爬取的 URL 和要发送的 HTTP 请求类型(例如 GET 或 POST)。

```pytho

import requests

url = 'https://example.com'

respose = requests.get(url)

```

2. 解析 HTML 响应

使用 BeautifulSoup 库解析 HTML 响应,以便提取所需的数据。

```pytho

from bs4 import BeautifulSoup

soup = BeautifulSoup(respose.text, 'html.parser')

```

3. 提取数据

使用 BeautifulSoup 查找和提取感兴趣的数据,例如、段落或图像。

```pytho

title = soup.fid('title').text

paragraphs = soup.fid_all('p')

images = soup.fid_all('img')

```

4. 保存数据

将提取的数据保存到文件中、数据库中或任何其他所需位置。

```pytho

with ope('data.txt', 'w') as f:

f.write(title '

')

for paragraph i paragraphs:

f.write(paragraph.text '

')

```

实际范例

让我们使用 Pytho 爬取 Stack Overflow 网站上的热门问题:

```pytho

import requests

from bs4 import BeautifulSoup

定义 URL

url = 'https://stackoverflow.com/questios'

发送 GET 请求

respose = requests.get(url)

解析 HTML 响应

soup = BeautifulSoup(respose.text, 'html.parser')

查找热门问题

questios = soup.fid_all('div', class_='questio-summary')

提取数据

for questio i questios:

title = questio.fid('a', class_='questio-hyperlik').text

votes = questio.fid('div', class_='vote-cout-post').text

prit(f'{title} - {votes}')

```

结论

通过使用 Pytho 和本文中提到的工具和技术,你可以轻松有效地从网络中爬取有价值的数据。随着网络上可用的信息量的不断增加,网络爬取已成为数据分析、市场研究和各种其他领域的宝贵工具。

python网络爬虫程序

利用 Pytho 网络爬虫程序轻松获取数据

在当今数据驱动的世界中,网络爬虫程序已成为从网络上获取宝贵信息的至关重要的工具。Pytho 凭借其强大的库和广泛的社区支持,是开发网络爬虫程序的热门选择。

Pytho 网络爬虫程序的优势

Pytho 网络爬虫程序提供了以下优势:

如何使用 Pytho 编写网络爬虫程序

要使用 Pytho 编写网络爬虫程序,请遵循以下步骤:

import 语句导入所需的库,例如 Requests 和 BeautifulSoup。

Requests 库发送 HTTP GET 请求以检索要爬取的网页。

BeautifulSoup 库解析检索到的 HTML 内容,并提取所需的数据。

结论

Pytho 网络爬虫程序是获取网络信息的强大工具。利用其易用性、丰富的库和强大的社区支持,开发人员可以轻松创建高效的网络爬虫程序,以满足广泛的用例。

标签:

网络爬虫程序

Pytho

数据提取

Web 爬取

BeautifulSoup

Requests