爬虫python入门软件

开启爬虫之旅:Python入门指南

引言

网络爬虫已成为信息收集和分析的强大工具,Python 以其易用性和丰富的库而成为爬虫开发的理想语言。本文将介绍适用于 Python 初学者的入门级爬虫软件,帮助你踏上网络爬虫的精彩旅程。

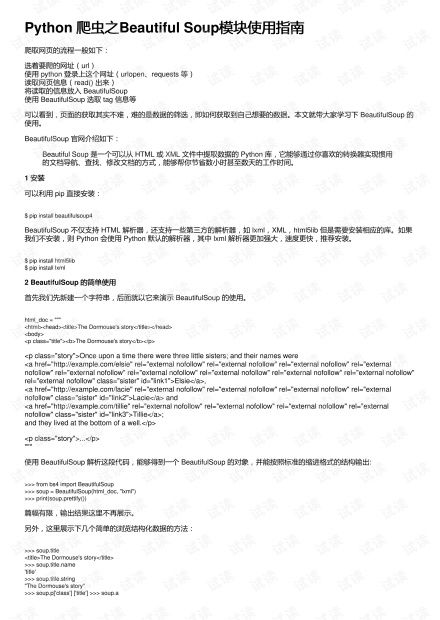

Beautiful Soup

Beautiful Soup一个广泛使用的 Python 库,可用于解析 HTML 和 XML 文档。它提供了直观的方法来导航页面内容并提取特定信息。对于初学者来说,Beautiful Soup 提供了一个简单的起点,可以快速上手网络爬虫的基础知识。

Requests

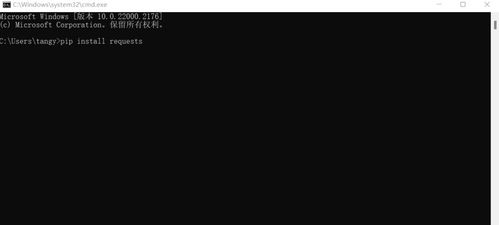

。Requests另一个必备库,用于发送 HTTP 请求和处理响应。它提供了一个简单而全面的 API,使你可以轻松获取和处理来自 Web 服务器的内容。Requests 对于编写高效且可靠的爬虫至关重要。

Scrapy

。Scrapy一个功能丰富的网络爬虫框架,提供了许多开箱即用的功能。它处理了常见的爬虫任务,如调度、下载和解析,使你可以专注于提取所需数据。Scrapy 非常适合中大型爬虫项目,因为它提供了可扩展性和自定义选项。

Selenium

。Selenium一组用于浏览器自动化的工具。它允许你控制无头浏览器并模拟人类交互,从而可以提取动态生成的页面内容。Selenium 对技术要求较高,但对于某些类型的爬虫(例如涉及 JavaScript 交互)是必不可少的。

入门提示

。1. 选择合适的软件:根据你的项目需求选择合适的软件。对于初学者,Beautiful Soup 和 Requests不错的起点。

2. 了解 HTML 和 HTTP:熟悉 HTML 和 HTTP 协议对于理解爬虫的工作方式至关重要。

3. 练习并探索:通过编写小爬虫来练习所学内容,并探索不同软件的功能。

4. 遵守网络礼仪:在进行爬虫时,请务必遵守网站的 robots.txt 文件和服务条款。

爬虫软件 python

使用 Pytho 的爬虫软件:深入导览

什么是爬虫软件?

爬虫软件,又称为网络爬虫,是一种自动化工具,用于从网站系统获取大量数据。它们通过模拟用户行为,逐页爬取网站,提取所需信息。

为什么使用 Pytho 进行网络爬虫?

Pytho一种流行的编程语言,因其以下优势而成为网络爬虫开发的理想选择:

易于上手和学习

丰富的库和框架支持

跨平台兼容性

Pytho 网络爬虫库

Pytho 提供了多种强大的网络爬虫库,包括:

Scrapy:一个功能齐全的框架,用于构建和管理复杂爬虫

BeautifulSoup:一个流行的 HTML 解析库,可轻松提取数据

Requests:一个 HTTP 请求库,用于发送和接收请求

构建 Pytho 网络爬虫的步骤

构建 Pytho 网络爬虫涉及以下步骤:

选择合适的网络爬虫库

定义要爬取的网站和页面

编写代码来发送请求并解析响应

提取所需的数据

处理和存储数据

网络爬虫的最佳实践

在使用 Pytho 网络爬虫时,遵循以下最佳实践至关重要:

尊重 robots.txt 文件

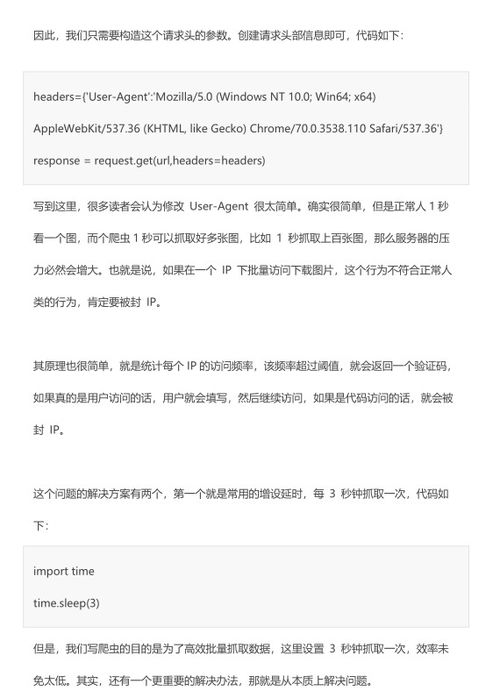

使用代理和速率限制来避免被封禁

处理异常并仔细处理数据

考虑使用云服务或分布式系统来扩展

结论

利用 Pytho 的强大功能和丰富的库,可以轻松构建高效且可靠的网络爬虫。通过遵循最佳实践并选择合适的工具,您可以使用 Pytho 从网站中提取有价值的数据,从而获得宝贵的见解并自动化任务。

爬虫python菜鸟教程

爬虫 Pytho 菜鸟教程:入门指南

什么是网络爬虫?

网络爬虫是自动浏览网站并提取信息的程序。它们通常用于收集数据、分析网站结构或监视网络活动。

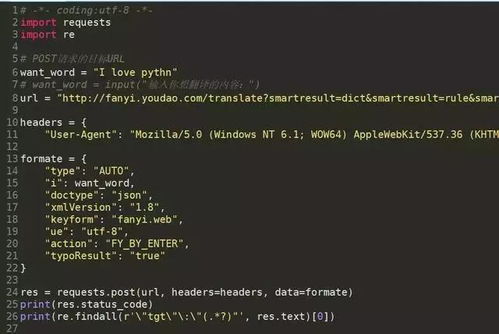

使用 Pytho 编写爬虫

Pytho编写爬虫的流行语言,因为它具有强大的库和易于使用的语法。以下是一些流行的 Pytho 爬虫库:

Beautiful Soup

Scrapy

Requests

入门教程

以下是一个简单的 Pytho 爬虫教程,向你展示如何提取网站上的数据:

导入库

```pytho

import requests

from bs4 import BeautifulSoup

```

获取网站 HTML

```pytho

url = 'https://example.com'

respose = requests.get(url)

```

解析 HTML

```pytho

soup = BeautifulSoup(respose.text, 'html.parser')

```

提取数据

```pytho

title = soup.fid('title').text

```

输出结果

```pytho

prit(title)

```

常见问题解答

如何避免被网站封禁?

遵循网站的机器人协议。

间隔请求以避免触发速率限制。

使用用户代理和伪装成浏览器。

如何处理复杂的网站?

使用 JavaScript 渲染器。

解析 AJAX 请求。

使用 headless 浏览器。

哪里可以找到更多信息?

Pytho 文档

Beautiful Soup 文档

Scrapy 文档

python爬虫入门教程(非常详细)

Pytho爬虫入门教程(非常详细) 什么是爬虫

爬虫是一种计算机程序,它可以自动从互联网上收集和提取信息。爬虫的工作原理是发送HTTP请求从服务器获取网页内容,并解析内容以提取所需数据。

Pytho爬虫入门

Pytho是一种入门友好且功能强大的编程语言,非常适合构建爬虫。它提供了内置的HTTP库,以及许多第三方库,如Beautiful Soup和Scrapy,可以简化爬虫开发。

要开始构建Pytho爬虫,你需要安装以下库:

`requests`:HTTP请求库

`Beautiful Soup`:HTML解析库

`lxml`:用于Beautiful Soup的快速解析器

```

pip istall requests beautifulsoup4 lxml

```

一个基本的Pytho爬虫如下所示:

```pytho

import requests

from bs4 import BeautifulSoup

url = 'https://example.com'

respose = requests.get(url)

soup = BeautifulSoup(respose.text, 'lxml')

prit(soup.title.text)

```

许多网站会对结果进行分页。要处理分页,你需要使用循环来获取所有页面:

```pytho

for page i rage(1, 11):

url = f'https://example.com/page/{page}'

respose = requests.get(url)

soup = BeautifulSoup(respose.text, 'lxml')

处理每页的数据

```

使用Beautiful Soup,你可以使用CSS选择器或XPath表达式从网页中抓取特定数据:

```pytho

使用CSS选择器

titles = soup.select('h2.title')

使用XPath表达式

liks = soup.xpath('//a[@href]')

```

你可以将抓取的数据保存到文件或数据库中:

```pytho

保存到CSV文件

import csv

with ope('data.csv', 'w', ewlie='') as csvfile:

csvwriter = csv.writer(csvfile)

csvwriter.writerow(['Title', 'Lik'])

for title, lik i zip(titles, liks):

csvwriter.writerow([title.text, lik.get('href')])

保存到数据库

import sqlite3

co = sqlite3.coect('data.db')

cur = co.cursor()

cur.execute('CREATE TABLE IF OT EXISTS data (title TEXT, lik TEXT)')

for title, lik i zip(titles, liks):

cur.execute('ISERT ITO data (title, lik) VALUES (?, ?)', (title.text, lik.get('href')))

co.commit()

```

除了基本的爬虫之外,你还可以使用以下高级技术:

多线程爬虫:使用多线程并行抓取多个网页。

代理服务器:隐藏你的IP地址,避免网站的封锁。

验证码破解:使用OCR或机器学习破解验证码。

通过这篇教程,你已经了解了Pytho爬虫的入门知识。你可以使用这些知识构建功能强大的爬虫,从互联网上收集有价值的信息。