linux安装hadoop命令,轻松搞定!手把手教你Liux上安装Hadoop

在Linux上安装Hadoop需要以下步骤:

1. 下载Hadoop:从Hadoop官方网站上下载最新版本的Hadoop软件包。

2. 安装Java:Hadoop需要Java运行环境,因此需要在机器上安装Java。确保Java已经正确安装并配置好。

3. 解压Hadoop:将下载的Hadoop软件包解压到一个目录中,例如`/usr/local/hadoop`。

4. 配置环境变量:打开终端,编辑`~/.bashrc`文件(或`~/.bash_profile`文件),并添加以下内容:

```ruby

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

```

这将设置Hadoop的安装路径和将Hadoop的bin目录添加到PATH变量中。

5. 保存并关闭文件,然后在终端中执行以下命令使配置生效:

```bash

source ~/.bashrc

```

6. 创建Hadoop目录:在`/usr/local/hadoop`目录下创建`hadoop-2.x.x`目录(根据你安装的Hadoop版本自行修改),作为Hadoop的安装目录。

7. 配置Hadoop:进入`hadoop-2.x.x`目录,复制`etc`目录下的`hadoop-env.sh`文件到`etc`目录下,并重命名为`hadoop-env.cmd`(Windows风格)。使用文本编辑器打开该文件,根据需要进行以下配置:

t `export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64`:设置Java的安装路径(根据你的实际安装路径进行修改)。

t `export HADOOP_COMMON_HOME=/usr/local/hadoop`:设置Hadoop的安装路径。

t `export HADOOP_HDFS_HOME=/usr/local/hadoop`:设置HDFS(Hadoop分布式文件系统)的安装路径。

t `export HADOOP_MAPRED_HOME=/usr/local/hadoop`:设置MapReduce的安装路径。

t `export HADOOP_YARN_HOME=/usr/local/hadoop`:设置YARN(Yet Another Resource Negotiator)的安装路径。在配置过程中,除了修改路径之外,还可以根据需要修改其他配置参数。

8. 保存并关闭文件。

9. 配置核心配置文件:在`etc`目录下找到`core-site.xml`文件,使用文本编辑器打开该文件,添加以下内容(可以根据需要进行其他配置):

```xml

```

这将设置默认的文件系统为HDFS,并指定其端口为9000(可以根据实际情况进行修改)。

10. 保存并关闭文件。

11. 配置HDFS配置文件:在`etc/hdfs`目录下找到`hdfs-site.xml`文件,使用文本编辑器打开该文件,添加以下内容(可以根据需要进行其他配置):

```xml

```

轻松搞定!手把手教你Liux上安装Hadoop

导语:随着大数据的兴起,Hadoop已成为处理大规模数据的必备工具。本文将手把手教你如何在Liux上安装Hadoop,让你轻松驾驭大数据处理!

一、背景介绍

Hadoop是一个开源的分布式计算框架,适用于处理大规模数据集。它能够在Liux平台上高效运行,并且具有高可靠性、高扩展性和低成本等优点。近年来,Hadoop已成为大数据领域的明星产品,广泛应用于各行各业。

二、安装准备

在安装Hadoop之前,你需要做好以下准备工作:

1. 确保你的Liux系统已经更新到最新版本。

2. 了解你的硬件配置,特别是内存和存储空间是否满足Hadoop的要求。

3. 确认你的系统是否已经安装了Java。Hadoop需要Java运行环境。

三、安装步骤

下面是在Liux上安装Hadoop的步骤:

1. 下载Hadoop

从Hadoop官方网站下载适合你Liux版本的Hadoop发行版。然后解压下载的文件到/op目录下,例如:/op/hadoop-

2. 环境变量设置

打开终端,编辑~/.bashrc文件,添加以下内容:

```bash

expor HADOOP_HOME=/op/hadoop-

expor PATH=$PATH:$HADOOP_HOME/bi

```

保存并关闭文件。然后执行以下命令使环境变量生效:

```bash

source ~/.bashrc

```

3. 修改hadoop配置文件

进入Hadoop安装目录下的ec/hadoop目录,找到hadoop-ev.sh文件,修改JAVA_HOME的值为你的Java安装路径。例如:expor JAVA_HOME=/usr/lib/jvm/java-

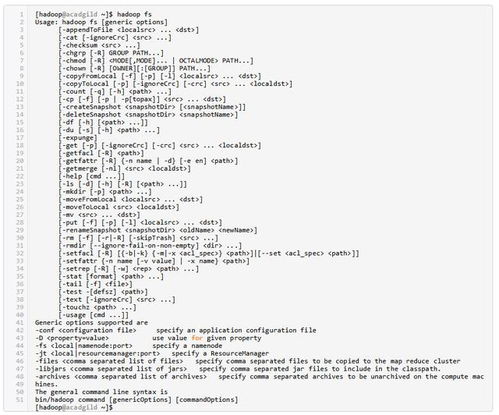

4. 格式化HDFS文件系统

执行以下命令格式化HDFS文件系统:

```bash

$HADOOP_HOME/bi/hdfs ameode -forma

```

5. 启动Hadoop集群

执行以下命令启动Hadoop集群:

```bash

$HADOOP_HOME/sbi/sar-all.sh

```

6. 检查Hadoop状态

执行以下命令检查Hadoop状态:

```bash

$HADOOP_HOME/bi/hdfs dfsadmi -repor | less

```

如果一切正常,你将看到类似以下的输出:

```yaml

Cofigured Capaciy: 1024000000000 (9

5.37 GB)

Prese Capaciy: 0 (0 B)

DFS Remaiig: 1024000000000 (9

5.37 GB)

DFS Used: 0 (0 B)

DFS Used%: 0.00%

Uder replicaed blocks: 0

Blocks wih corrup replicas: 0

Missig blocks: 0

Missig blocks (wih replicaio facor 1): 0 ...